Program basis data pencari file internet dengan info lokasi hadir sebagai solusi canggih untuk menavigasi belantara data digital yang tersebar di dunia maya. Teknologi ini tidak hanya sekadar mencari file, tetapi juga melengkapi setiap hasil dengan informasi geolokasi yang akurat, memberikan konteks spasial yang sangat berharga bagi penggunanya.

Dibangun di atas arsitektur yang robust, program ini menggabungkan teknik crawling yang komprehensif, metode pengindeksan yang efisien, dan algoritma pencarian yang pintar. Hasilnya adalah sebuah sistem yang mampu mengatasi kompleksitas format file beragam dan menyajikan informasi lokasi melalui integrasi yang mulus dengan layanan peta, menjawab kebutuhan akan penelusuran yang lebih terarah dan bermakna.

Konsep Dasar dan Arsitektur Program

Source: zukii-vixii.com

Program basis data pencari file internet beroperasi pada prinsip inti untuk mengumpulkan, mengorganisir, dan memungkinkan pencarian cepat terhadap informasi file beserta lokasinya di web. Prinsip utama yang mendasarinya adalah crawling (perayapan), indexing (pengindeksan), dan querying (pencarian). Program secara otomatis merayap melalui jaringan internet, mengambil metadata dan informasi lokasi dari berbagai file, kemudian menyimpannya dalam basis data terstruktur yang dioptimalkan untuk pencarian instan.

Arsitektur Sistem Program Pencari File

Arsitektur sistem ini dapat divisualisasikan sebagai sebuah alur kerja yang terdiri dari beberapa komponen utama. Diagram bloknya dimulai dari komponen Crawler yang bertugas menjelajahi internet. Data mentah yang dikumpulkan crawler kemudian diproses oleh komponen Indexer, yang mengekstrak dan menormalisasi informasi penting. Hasil indeks disimpan dalam Database Storage. Saat pengguna memasukkan kueri, komponen Query Processor akan menerjemahkannya dan mencari kecocokan di dalam indeks, lalu hasilnya disajikan melalui User Interface.

Seluruh proses ini dikoordinasikan oleh sebuah sistem manajemen yang memastikan setiap bagian berjalan harmonis.

Komponen Perangkat Lunak Penting

Untuk menjalankan funksinya secara efektif, program harus memiliki sejumlah komponen perangkat lunak yang saling mendukung. Masing-masing komponen memiliki peran kritis dalam menjaga keandalan dan kecepatan sistem.

- Crawler/Spider: Modul yang secara sistematis menjelajahi world wide web untuk menemukan dan mengunduh informasi tentang file.

- Indexer: Perangkat yang menganalisis halaman web dan file yang ditemukan crawler, mengekstrak kata kunci, metadata, dan informasi lokasi, lalu membangun indeks pencarian.

- Database Management System (DBMS): Sistem seperti PostgreSQL atau Elasticsearch yang menyimpan data terindeks secara terstruktur dan teroptimasi.

- Query Processor: Mesin yang menangani permintaan pencarian dari pengguna, mencocokkannya dengan indeks, dan mengembalikan hasil yang relevan.

- User Interface (UI): Layer antarmuka, biasanya berbasis web, tempat pengguna berinteraksi dengan sistem pencarian.

Perbandingan Arsitektur Terpusat dan Terdistribusi

Pemilihan antara arsitektur terpusat dan terdistribusi memiliki dampak signifikan pada kinerja, skalabilitas, dan kompleksitas sistem. Arsitektur terpusat menyimpan semua data dan pemrosesan pada satu server utama. Pendekatan ini lebih sederhana untuk diimplementasikan dan dikelola pada skala kecil, namun menjadi bottleneck dan rentan terhadap kegagalan tunggal ketika volume data sangat besar. Sebaliknya, arsitektur terdistribusi memecah beban kerja across multiple servers atau node.

Arsitektur ini menawarkan skalabilitas horizontal yang jauh lebih baik dan ketahanan yang更高, karena kegagalan satu node tidak melumpuhkan seluruh sistem. Namun, kompleksitas desain, implementasi, dan pemeliharaannya juga jauh lebih tinggi.

Metode Pengindeksan dan Pencarian Data

Inti dari sebuah mesin pencari file yang powerful terletak pada efisiensi metode pengindeksan dan kecerdasan algoritma pencariannya. Proses ini menentukan seberapa cepat dan akurat sistem dapat merespons permintaan pengguna dari lautan data yang tersimpan.

Proses Crawling dan Pengindeksan File

Crawling dimulai dengan memberikan daftar seed URL kepada crawler. Crawler kemudian mengunjungi URL tersebut, mengambil kontennya, dan mengekstrak semua tautan yang ditemukan untuk ditambahkan ke antrian perayapan berikutnya. Untuk setiap file yang ditemukan (seperti PDF, DOC, atau gambar), crawler mengambil informasi mentahnya. Proses pengindeksan kemudian mengambil alih. Indexer akan menganalisis file-file ini, mengekstrak teks lengkap (untuk dokumen), metadata (seperti nama pembuat, tanggal modifikasi, dan ukuran file), dan informasi lokasi yang disematkan.

Program basis data pencari file internet dengan info lokasi memudahkan akses informasi publik, sebuah hak digital warga di era modern. Namun, hak ini beriringan dengan kewajiban untuk menggunakan teknologi secara bertanggung jawab, sebagaimana dijelaskan dalam ulasan 5 Contoh Hak dan Kewajiban dalam Masyarakat. Prinsip keseimbangan hak dan kewajiban inilah yang juga menjadi fondasi etis dalam pengembangan dan pemanfaatan teknologi pencarian informasi untuk kemaslahatan bersama.

Data ini kemudian dinormalisasi, dibersihkan, dan disimpan dalam struktur data khusus, seperti inverted index, yang memetakan setiap kata kunci ke daftar file yang memuatnya.

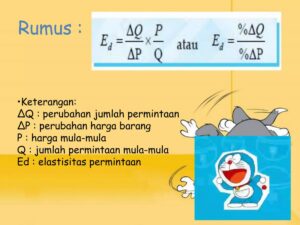

Perbandingan Metode Pengindeksan

Pemilihan metode pengindeksan bergantung pada trade-off antara kecepatan dan akurasi yang diinginkan. Beberapa metode umum digunakan dengan karakteristik yang berbeda-beda.

| Metode Pengindeksan | Kecepatan Pencarian | Akurasi Hasil | Keterangan |

|---|---|---|---|

| Full-Text Indexing | Cenderung Lebih Lambat | Mengindeks seluruh konten teks file, menghasilkan recall yang sangat baik tetapi membutuhkan lebih banyak ruang penyimpanan dan waktu pemrosesan. | |

| Metadata Indexing | Sangat Cepat | Terbatas | Hanya mengindeks field terstruktur seperti nama file, penulis, dan tanggal. Sangat cepat tetapi dapat melewatkan hasil yang relevan jika kata kunci tidak ada di metadata. |

| Field-Specific Indexing | Cepat | Tinggi | Mengindeks field tertentu (misalnya, hanya ‘judul’ dan ‘ringkasan’) yang telah ditentukan, menyeimbangkan kecepatan dan cakupan. |

| Hashing & Fingerprinting | Sangat Cepat | Eksak | Digunakan untuk mendeteksi file duplikat. Membuat hash unik dari konten file. Pencarian bersifat eksak match, bukan berdasarkan relevansi. |

Algoritma Pencarian dan Pencocokan Kueri

Algoritma pencarian bekerja melalui serangkaian langkah terstruktur untuk menghasilkan hasil yang relevan. Pertama, kueri pengguna diterima dan melalui proses tokenization, di mana string kueri dipecah menjadi kata-kata individual. Selanjutnya, kata-kata ini menjalani normalisasi, yang mencakup converting to lowercase, stemming (mengurangi kata ke bentuk dasarnya, seperti “mencari” menjadi “cari”), dan menghapus stop words (kata umum seperti “dan”, “di”).

Setelah itu, algoritma mencari token yang telah dinormalisasi ini dalam inverted index untuk mendapatkan daftar dokumen yang memuatnya. Akhirnya, hasil ini diberi peringkat berdasarkan algoritma ranking seperti TF-IDF (Term Frequency-Inverse Document Frequency) atau BM25, yang mengevaluasi seberapa penting sebuah kata dalam dokumen relatif terhadap seluruh koleksi, sehingga dokumen yang paling relevan muncul di posisi teratas.

Tantangan Pengindeksan Multi-Format dan Solusinya

Internet dipenuhi dengan berbagai format file, masing-masing menyimpan informasinya dengan cara yang unik, menciptakan tantangan besar untuk pengindeksan. File teks seperti TXT atau HTML relatif mudah, sedangkan dokumen seperti PDF dan DOCX memerlukan library khusus (seperti Apache Tika) untuk mengekstrak teksnya. Tantangan yang lebih besar muncul pada file binary seperti gambar, audio, dan video. Untuk mengindeksnya, sistem tidak dapat membaca “teks” di dalamnya secara langsung.

Solusinya adalah dengan mengandalkan metadata yang disematkan (seperti EXIF pada gambar) atau menggunakan teknik AI seperti Computer Vision untuk menganalisis dan men-generate tag deskriptif dari konten visual (misalnya, “gunung”, “pantai”, “3 orang”). Solusi komprehensifnya adalah menerapkan pipeline ekstraksi konten yang dapat menangani ratusan format berbeda, memastikan tidak ada file yang terlewat.

Manajemen dan Penyimpanan Basis Data: Program Basis Data Pencari File Internet Dengan Info Lokasi

Kekuatan dan keandalan program pencari file sangat bergantung pada bagaimana data yang telah diindeks disimpan dan dikelola. Struktur basis data yang optimal bukan hanya tentang menyimpan informasi, tetapi juga tentang memastikan kecepatan akses, integritas data, dan kemudahan scaling di masa depan.

Struktur Skema Basis Data Optimal

Skema basis data untuk sistem ini biasanya dirancang secara normalisasi untuk menghindari redundansi data dan memastikan konsistensi. Beberapa tabel kunci yang umum digunakan antara lain: Tabel `files` yang menyimpan inti informasi setiap file seperti `file_id` (primary key), `file_name`, `file_size`, `file_type`, `url`, dan `hash_content`. Tabel `file_metadata` yang menyimpan metadata spesifik dalam format key-value, terkait ke `file_id`, misalnya `metadata_key` (seperti ‘author’, ‘creation_date’) dan `metadata_value`.

Tabel `locations` yang mencatat informasi geolokasi yang terkait dengan sebuah file, dengan field seperti `location_id`, `file_id` (foreign key), `latitude`, `longitude`, `country_code`, dan tingkat akurasi. Serta Tabel `index_terms` yang merupakan implementasi dari inverted index, dengan kolom `term` (kata yang diindeks) dan `posting_list` (berisi referensi ke `file_id` dan informasi bobot lainnya).

Teknik Menjaga Integritas dan Konsistensi Data

Dalam lingkungan di mana data terus diperbarui oleh banyak crawler, menjaga integritas data adalah hal yang mutlak. Teknik yang umum diterapkan adalah penggunaan constraints pada level database, seperti PRIMARY KEY, FOREIGN KEY, dan UNIQUE constraints untuk mencegah data duplikat dan tidak valid. Transaksi database (ACID properties) digunakan untuk memastikan bahwa operasi update data要么 dilakukan sepenuhnya,要么 tidak sama sekali, menghindari inkonsistensi.

Untuk data yang berasal dari sumber tidak terpercaya, validasi data sebelum dimasukkan ke dalam database adalah langkah penting. Selain itu, penerapan periodic data cleansing jobs membantu mengidentifikasi dan memperbaiki atau menghapus data yang sudah usang atau korup.

Strategi Penanganan Pertumbuhan Data dan Scaling

Volume data internet yang terus bertambah mengharuskan sistem penyimpanan dapat diskalakan. Vertical scaling (menambah kapasitas server existing) memiliki batas praktis dan finansial. Horizontal scaling menjadi pilihan yang lebih feasible, yaitu dengan mempartisi data across multiple database servers. Dua strategi umumnya adalah: Sharding, yaitu memecah tabel besar berdasarkan suatu kunci (misalnya, berdasarkan rentang `file_id` atau huruf pertama nama file) dan mendistribusikannya ke beberapa server database.

Replikasi, yaitu membuat salinan (replica) dari basis data untuk tujuan read-only. Replica ini menangani beban pencarian, sementara database utama (master) menangani operasi tulis. Kombinasi sharding dan replikasi sering digunakan untuk membangun sistem yang sangat skalabel dan toleran terhadap kegagalan.

Integrasi dan Penyediaan Informasi Lokasi

Fitur pembeda dari program ini adalah kemampuannya tidak hanya menemukan file, tetapi juga melacak dan menampilkan dari mana file tersebut berasal. Integrasi informasi lokasi menambahkan layer kontekstual yang sangat berharga bagi pengguna, mengubah data mentah menjadi informasi yang dapat ditindaklanjuti.

Metode Pengaitan Informasi Geolokasi

Mengaitkan informasi geolokasi secara akurat kepada setiap file dilakukan melalui beberapa metode. Untuk file yang secara eksplisit menyimpan data geotag, seperti foto JPEG dengan metadata GPS, sistem dapat mengekstrak koordinat latitude dan longitude secara langsung. Metode lain adalah dengan menganalisis sumber file tersebut diunduh. Jika file ditemukan pada server web, lokasi fisik server dapat memberikan petunjuk, meskipun ini tidak selalu akurat karena penggunaan Content Delivery Networks (CDN).

Teknik yang lebih canggih adalah menganalisis konten teks dalam file atau halaman web tempatnya ditemukan untuk menyebutkan nama tempat tertentu, yang kemudian dapat di-resolve ke koordinat menggunakan Geocoding API dari layanan seperti Google Maps atau OpenStreetMap.

Penanganan Informasi Lokasi yang Ambigu

Sangat umum untuk menemukan file dengan informasi lokasi yang ambigu, tidak lengkap, atau bahkan bertentangan. Prosedur untuk menanganinya memerlukan logika yang jelas. Sistem pertama-tama akan mencoba mengukur confidence score dari setiap sumber lokasi (misalnya, GPS tag memiliki confidence更高 daripada teks yang menyebutkan nama kota). Jika terdapat multiple sources, sistem dapat melakukan voting atau mengambil nilai rata-rata jika berupa koordinat. Untuk teks yang ambigu (misalnya, “Springfield”), sistem mungkin menyimpan beberapa kemungkinan lokasi atau meminta kontekstualisasi lebih lanjut dari pengguna.

Dalam kasus dimana tidak ada informasi yang dapat ditemukan, field lokasi dapat dibiarkan NULL daripada menebak yang bisa menyesatkan.

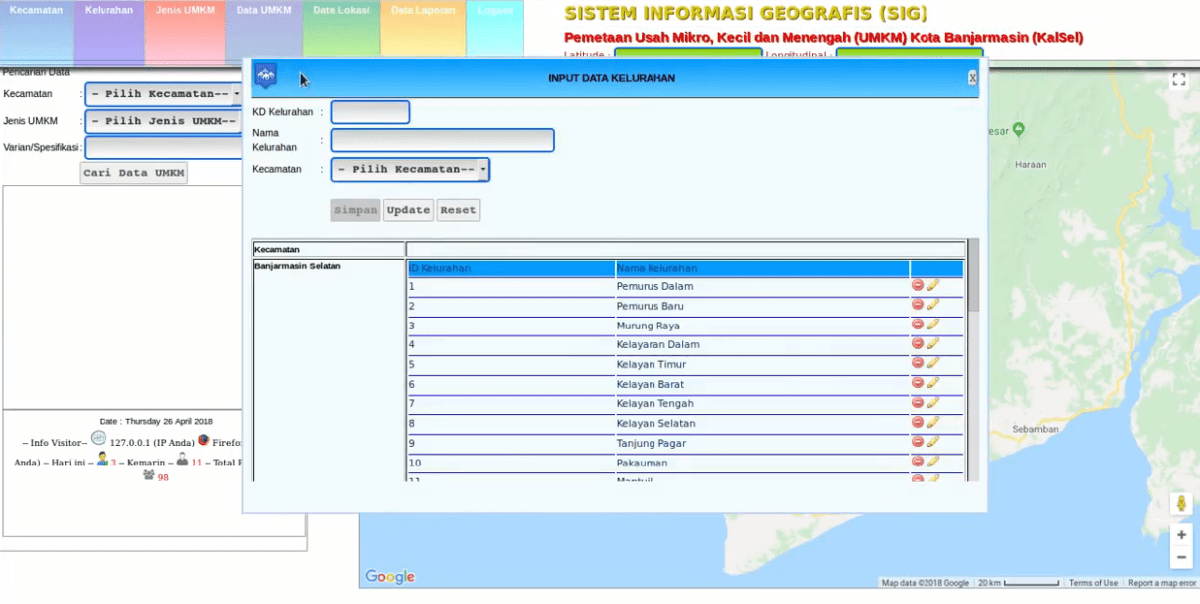

Visualisasi Informasi Lokasi kepada Pengguna

Informasi lokasi menjadi paling berguna ketika disajikan secara visual dan interaktif. Cara paling intuitif adalah dengan mengintegrasikan layanan peta seperti Leaflet.js atau Google Maps API ke dalam antarmuka pengguna. Hasil pencarian dapat menampilkan daftar file yang relevan, dan untuk file yang memiliki data lokasi, ikon pin kecil atau link “Tampilkan di Peta” disertakan. Ketika pengguna mengkliknya, sebuah panel peta interaktif akan muncul dengan pin yang ditempatkan pada koordinat yang tepat.

Pengguna dapat melihat kluster file berdasarkan wilayah, memberikan pemahaman spasial yang langsung tentang distribusi data. Fitur filter hasil pencarian berdasarkan radius sekitar suatu titik koordinat juga dapat ditambahkan untuk memperkaya pengalaman.

Antarmuka Pengguna dan Pengalaman

Antarmuka pengguna adalah gerbang utama interaksi antara pengguna dengan teknologi kompleks yang ada di baliknya. Desain yang intuitif, cepat, dan powerful sangat penting untuk mentransformasikan kemampuan teknis program menjadi nilai yang dapat dirasakan langsung oleh pengguna.

Wireframe Antarmuka Pencarian Utama

Antarmuka pencarian utama dirancang untuk memprioritaskan kesederhanaan dan kecepatan. Di bagian paling atas halaman, terdapat bilah pencarian (search bar) yang mencolok dan menjadi focal point, dengan placeholder text yang mengundang seperti “Cari file di internet…”. Di sebelah kanan bilah pencarian, tombol “Cari” dan tombol “Filter Lanjutan” ditempatkan. Di bawah bilah pencarian, area hasil pencarian menampilkan daftar file dalam bentuk kartu (card) atau baris.

Setiap item hasil menampilkan ikon jenis file, nama file, pratinjau metadata singkat (ukuran, jenis, sumber), dan cuplikan (snippet) teks yang menunjukkan konteks kecocokan. Di sisi kiri halaman, panel filter yang dapat disembunyikan/diturunkan (collapsible) menampung berbagai opsi penyaringan.

Program basis data pencari file internet dengan info lokasi memungkinkan kita melacak dan mengorganisir informasi kompleks secara efisien, mirip cara ilmuwan melacak Tahap‑tahap Metagenesis pada Aurelia aurita yang rumit. Teknologi ini, dengan presisi dan otoritas data yang tinggi, pada akhirnya mempermudah pengguna dalam menemukan dan memverifikasi lokasi file yang dibutuhkan di dunia digital.

Fitur Filter Hasil Pencarian

Panel filter adalah alat penting bagi pengguna untuk mempersempit hasil pencarian yang luas menjadi sesuatu yang sangat spesifik dan relevan. Fitur filter yang komprehensif mencakup penyaringan berdasarkan jenis file (misalnya, PDF, DOCX, JPEG, MP4), yang memungkinkan pengguna hanya fokus pada format yang mereka butuhkan. Filter berdasarkan rentang tanggal sangat penting untuk menemukan file yang baru dibuat atau dimodifikasi. Filter geografis memungkinkan pengguna membatasi hasil berdasarkan negara, region, atau bahkan dengan menggambar radius pada peta.

Filter berdasarkan ukuran file membantu menemukan file yang ringan atau besar sesuai kebutuhan. Selain itu, filter berdasarkan sumber atau domain website asal file juga dapat ditambahkan untuk akurasi yang lebih tinggi.

Alur Kerja Pengguna dari Pencarian hingga Hasil

Alur kerja pengguna dirancang agar lancar dan bebas hambatan. Pengguna memasuki halaman dan langsung memasukkan kata kunci pencarian ke dalam bilah pencarian utama. Setelah menekan enter, hasil langsung ditampilkan secara real-time (jika didukung oleh teknologi seperti AJAX). Pengguna dapat dengan cepat memindai hasil. Jika hasil terlalu banyak, pengguna dapat membuka panel filter di sebelah kiri dan menerapkan satu atau kombinasi filter.

Setiap kali filter diterapkan, daftar hasil diperbarui secara dinamis tanpa perlu me-refresh seluruh halaman. Pengguna dapat mengurutkan hasil berdasarkan relevansi, tanggal, atau ukuran file. Ketika menemukan file yang diinginkan, pengguna dapat mengkliknya untuk melihat detail lengkap, pratinjau, atau opsi untuk mengunduh langsung. Seluruh alur ini memastikan pengguna dapat menemukan apa yang mereka cari dalam langkah yang minimal.

Optimasi Kinerja dan Keandalan Sistem

Membangun program yang fungsional adalah satu hal, tetapi memastikannya tetap cepat dan online bahkan di bawah beban yang berat adalah hal lain yang sama pentingnya. Optimasi kinerja dan desain untuk keandalan tinggi adalah investasi kritikal untuk pengalaman pengguna yang mulus.

Mengidentifikasi dan Mengatasi Kemacetan Performa

Kemacetan performa (bottleneck) dapat terjadi di berbagai titik dalam sistem. Operasi I/O pada database sering menjadi tersangka utama, terutama untuk query yang kompleks terhadap miliaran record. Optimasinya melibatkan pembuatan indeks database yang tepat pada kolom yang sering digunakan untuk pencarian dan filtering. Bottleneck lain adalah proses crawling dan indexing yang memakan sumber daya CPU dan bandwidth. Hal ini dapat diatasi dengan mengatur politeness delay (jeda antar permintaan ke satu website) dan melakukan distributed crawling.

Pada layer antarmuka, latency dapat dikurangi dengan meminimalkan ukuran aset (mengompresi gambar, CSS, JS) dan menggunakan Content Delivery Networks (CDN) untuk menyajikan aset-aset tersebut dari lokasi yang dekat dengan pengguna.

Penerapan Teknik Caching yang Efektif, Program basis data pencari file internet dengan info lokasi

Caching adalah teknik paling efektif untuk mengurangi beban database dan mempercepat respons. Beberapa layer caching dapat diterapkan. Pertama, Query Caching, di mana hasil dari query pencarian yang sering dilakukan disimpan dalam memory (menggunakan Redis atau Memcached) untuk periode waktu tertentu. Ketika query yang sama diminta lagi, hasilnya dapat dilayani dari cache tanpa perlu mengganggu database. Kedua, Object Caching, yang menyimpan objek data yang sering diakses, seperti hasil render halaman detail sebuah file populer.

Program basis data pencari file internet dengan info lokasi tidak hanya mengorganisir data digital, tetapi juga menginspirasi eksplorasi pengetahuan geologis. Seperti halnya memahami Pengertian Litosfer , lapisan batuan terluar Bumi yang menjadi fondasi kehidupan, program ini menjadi fondasi penting dalam navigasi dan pengambilan data spasial dari berbagai sumber di internet secara lebih terstruktur dan efisien.

Ketiga, CDN Caching, yang menyimpan salinan aset statis dan bahkan konten dinamis di edge server yang tersebar secara global, sehingga mengurangi latensi untuk pengguna di berbagai belahan dunia.

Memastikan Ketersediaan Tinggi dan Keandalan

Ketersediaan tinggi (high availability) berarti sistem dirancang untuk tetap beroperasi terus-menerus, bahkan ketika komponen individualnya gagal. Ini dicapai melalui redundansi pada setiap level. Load balancer didistribusikan di depan fleet application server untuk membagi traffic dan melakukan health check. Database direplikasi, dengan satu primary node menangani tulis dan beberapa replica node menangani bacaan. Jika primary node gagal, sistem failover dapat secara otomatis mempromosikan sebuah replica menjadi primary baru.

Mekanisme backup yang robust juga sangat penting. Backup data dilakukan secara berkala (harian, mingguan) dan disimpan di lokasi off-site atau cloud storage yang terpisah. Prosedur recovery harus secara teratur diuji untuk memastikan data dapat dipulihkan dengan cepat dan lengkap dalam skenario bencana, meminimalkan downtime dan kehilangan data.

Kesimpulan

Keberadaan program semacam ini merepresentasikan lompatan signifikan dalam cara kita berinteraksi dengan informasi digital. Ia mentransformasi proses pencarian dari aktivitas yang bersifat umum menjadi pengalaman yang terpersonalisasi dan kontekstual, di mana setiap file ditemukan tidak hanya berdasarkan namanya, tetapi juga berdasarkan cerita di balik lokasinya. Inilah masa depan penelusuran data, yang menawarkan presisi dan kedalaman insight yang sebelumnya sulit dibayangkan.

FAQ dan Informasi Bermanfaat

Apakah program ini dapat mencari file di semua jenis website?

Tidak sepenuhnya. Kemampuan crawler program dibatasi oleh kebijakan robots.txt sebuah website dan jenis konten yang diizinkan untuk diakses secara publik. Website dengan paywall atau yang memerlukan otentikasi umumnya tidak dapat diindeks.

Bagaimana akurasi informasi lokasi yang diberikan?

Akurasi bervariasi tergantung sumber file. Untuk file dengan metadata GPS embedded, seperti beberapa foto, akurasinya sangat tinggi. Untuk sumber lain, lokasi diperkirakan berdasarkan alamat IP server atau informasi yang tersedia, yang mungkin kurang spesifik.

Apakah penggunaan program ini memerlukan keahlian teknis khusus?

Antarmuka pengguna dirancang untuk digunakan oleh berbagai kalangan. Fitur pencarian dasar mudah digunakan, sementara fitur filter lanjutan seperti query geospasial mungkin memerlukan pemahaman dasar untuk hasil yang optimal.

Bagaimana program menangani privasi data dan informasi sensitif?

Program hanya mengindeks informasi yang tersedia untuk umum. File yang tidak terindeks oleh mesin pencari biasa atau yang berada di direktori terproteksi tidak akan diakses. Namun, selalu ada tanggung jawab untuk menggunakan informasi yang ditemukan secara etis.